IO内存映射深度实践:ioremap与regmap寄存器操作对比及最佳方案

立即解锁

发布时间: 2025-10-17 21:52:02 阅读量: 33 订阅数: 29 AIGC

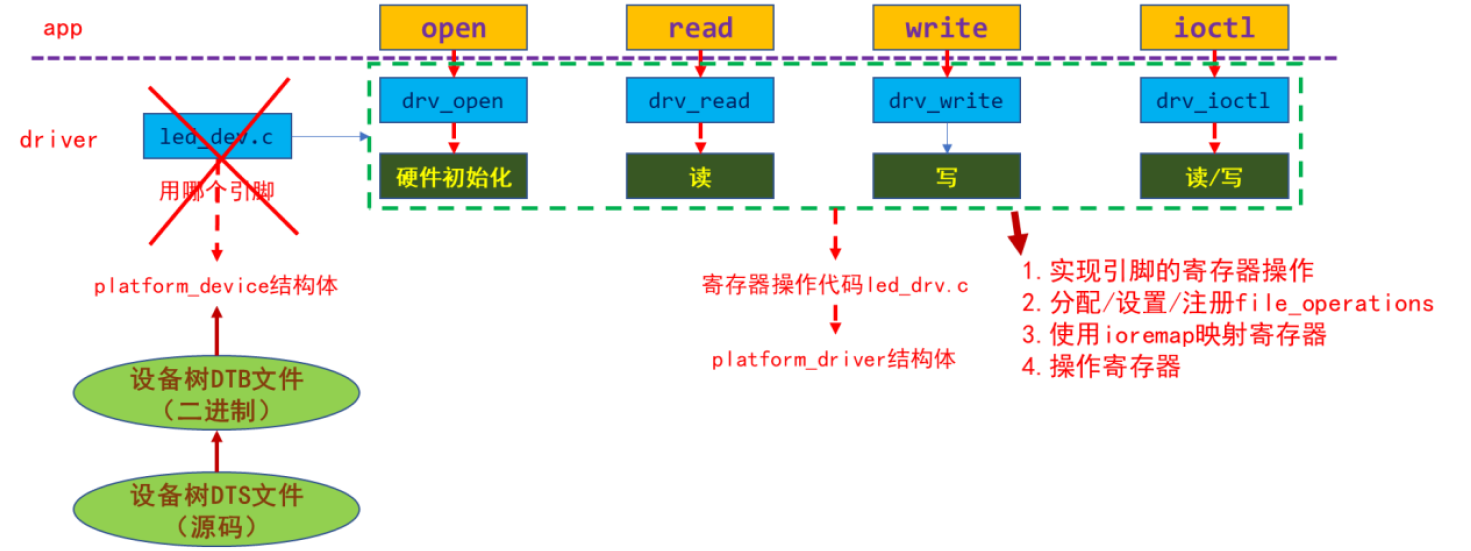

Linux驱动层操作物理地址程序,采用ioremap实现物理地址读写,与应用层采用字符驱动框架,并通过IO-CTL方式进行交互

# 1. IO内存映射技术概述

在Linux内核驱动开发中,IO内存映射技术是实现CPU访问外设寄存器的关键机制。由于现代处理器采用虚拟内存体系,外设的物理地址无法直接被内核代码访问,必须通过映射机制将其关联到内核虚拟地址空间。`ioremap` 和 `regmap` 是两种核心实现方式,分别代表了底层直接映射与高层抽象封装的设计哲学。

该技术不仅涉及页表管理、地址转换等MMU底层原理,还需考虑内存屏障、缓存一致性及访问原子性等关键问题。随着SoC复杂度提升,寄存器访问的安全性、可维护性与跨平台兼容性日益重要,推动了从传统 `ioremap` 向结构化 `regmap` 架构的演进。本章为后续深入剖析两类机制奠定理论基础。

# 2. ioremap机制深入解析与实践应用

在现代嵌入式系统和Linux内核驱动开发中,硬件资源的访问往往需要通过内存映射技术来实现。其中,`ioremap` 是 Linux 内核提供的一种关键机制,用于将设备的物理地址空间映射到内核虚拟地址空间,从而允许驱动程序以指针方式直接读写外设寄存器。尽管其接口看似简单——仅是一个函数调用,但背后涉及复杂的页表管理、内存保护策略以及体系结构相关的实现细节。对于拥有5年以上经验的内核开发者而言,理解 `ioremap` 的底层原理不仅是编写稳定驱动的基础,更是优化性能、排查疑难问题的关键所在。

本章将从 `ioremap` 的基本原理出发,深入剖析其在内核中的实现机制,涵盖虚拟内存与物理地址之间的映射关系、页表操作流程,并结合实际代码分析其执行路径。随后,详细介绍 `ioremap` 和 `iounmap` 的编程接口使用方法,包括参数含义、常见陷阱及最佳实践。最后,通过真实驱动案例展示如何利用 `ioremap` 访问硬件寄存器,并探讨映射失败、地址对齐异常、权限错误等典型问题的成因与解决方案。整个内容由浅入深,既适合有一定基础的驱动开发者巩固知识体系,也为高级工程师提供可延伸的技术思考空间。

## 2.1 ioremap的原理与内核实现

`ioremap` 的核心作用是建立一段不可缓存的、非线性映射的虚拟地址区域,使其指向指定的物理地址范围,通常用于访问 SoC 外设寄存器或 FPGA 模块等 I/O 内存区域。与用户空间的 `mmap` 不同,`ioremap` 工作在内核态,不涉及进程地址空间管理,而是直接修改内核页表(kernel page tables),因此其实现依赖于具体的 MMU 架构和内核内存管理子系统。

该机制的设计初衷在于解决以下问题:大多数外设寄存器位于固定的物理地址上(如 ARM 平台上的 0x10000000),而这些地址并不在常规的物理内存映射范围内(如 DRAM 区域)。若直接使用物理地址进行指针访问,在启用 MMU 的系统中会导致页错误。因此必须通过页表机制将其“映射”为有效的虚拟地址,且需确保该映射具有正确的属性——例如禁止缓存(uncacheable)、写合并(write-combined)或强序访问(strongly ordered),以符合外设访问语义。

### 2.1.1 虚拟内存与物理地址映射关系

在支持虚拟内存的处理器架构中(如 x86、ARM、RISC-V),CPU 所有内存访问都基于虚拟地址,实际的物理地址转换由 MMU(Memory Management Unit)完成,依赖于页表结构。Linux 内核为此维护了两套主要的地址空间:用户空间线性映射区和内核空间非线性映射区。`ioremap` 正是工作在后者之中。

内核空间一般划分为多个区域:

| 区域 | 起始地址(ARM32示例) | 描述 |

|------|------------------------|------|

| ZONE_NORMAL | 0xC0000000 | 直接映射的物理内存,一对一映射 |

| VMALLOC 区域 | 0xFF000000 ~ 0xFFBFFFFF | 动态分配的大块虚拟内存 |

| ioremap 区域 | 0xFFC00000 ~ 0xFFFFFFFF | 专用于 I/O 内存映射 |

> 注:具体地址布局因架构而异,此处以传统 ARM32 为例说明逻辑分区。

当调用 `ioremap(phys_addr, size)` 时,内核会在 `VMALLOC` 区域附近预留一块连续的虚拟地址空间(称为 `vmalloc` 区),并通过修改页表项(PTEs 或 PMD/PUD 条目)将该虚拟区间映射到底层物理地址。这一过程不分配实际物理内存,仅更新页表属性。

```c

void __iomem *ioremap(resource_size_t offset, unsigned long size)

{

return __ioremap_caller(offset, size, __pgprot(__PAGE_KERNEL_NC),

__builtin_return_address(0));

}

```

上述代码为 `ioremap` 的入口函数,其中:

- `offset`:目标设备寄存器的物理起始地址;

- `size`:映射区域大小(字节);

- `__pgprot(__PAGE_KERNEL_NC)`:指定页保护属性,NC 表示“No Cache”,即非缓存模式;

- `__builtin_return_address(0)`:用于调试追踪调用栈。

该函数最终会调用 `__ioremap_pte_range()` 或更高层级的 `pmd`/`pud` 映射函数,逐级构建页表条目。

#### 映射流程的mermaid图示

```mermaid

graph TD

A[调用ioremap(phys_addr, size)] --> B{是否已存在映射?}

B -->|否| C[分配vm_struct结构]

C --> D[查找可用虚拟地址区间]

D --> E[调用arch_add_memory_region()]

E --> F[遍历页表层级: pgd -> pud -> pmd -> pte]

F --> G[设置PTE标志位: _PAGE_PRESENT \| _PAGE_RO \| _PAGE_SPECIAL]

G --> H[禁用缓存: 设置MTTYPEn为Device-nGnRE]

H --> I[返回__iomem类型虚拟地址]

I --> J[驱动可通过readl/writel访问]

B -->|是| K[返回已有映射地址]

```

此流程清晰地展示了从函数调用到页表建立的全过程。值得注意的是,`__iomem` 是一种类型修饰符(qualifier),用于标记指针指向的是 I/O 内存而非普通 RAM,防止误用标准内存拷贝函数(如 `memcpy`)造成硬件损坏。

此外,不同架构对页表处理方式存在差异。例如在 ARM64 上,`ioremap` 使用 `create_mapping_late()` 函数动态添加映射;而在 x86 上则可能借助 `set_memory_uc()` 实现页属性更改。这种架构相关性要求开发者在跨平台移植时格外注意页表配置的一致性。

#### 关键数据结构分析

`ioremap` 的实现依赖以下几个核心结构体:

```c

struct vm_struct {

struct vm_struct *next;

void *addr; // 分配的虚拟地址

unsigned long size; // 区域大小

phys_addr_t phys_addr; // 对应物理地址(可选)

pgprot_t flags; // 页保护标志

struct page **pages; // 页面数组(适用于高端内存)

unsigned int nr_pages; // 页面数量

const void *caller;

};

```

每次成功调用 `ioremap` 都会在内核中注册一个 `vm_struct` 实例,记录映射信息。这些结构通过 `vmlist` 链表组织,便于后续查询和释放。

另一个重要结构是页表项本身。以 ARM64 为例,一个 PTE(Page Table Entry)包含如下字段:

| Bit Range | Name | Meaning |

|-----------|------|---------|

| [55:12] | Output Address | 物理页基地址 |

| [11:9] | AttrIdx | 内存类型索引(MT_NORMAL, MT_DEVICE_nGnRnE 等) |

| [8] | NS | 安全状态(Secure/Non-Secure) |

| [7:2] | Flags | 可执行、可写、有效等标志 |

| [1:0] | Valid & Type | 条目有效性及类型 |

其中,`AttrIdx` 指向 `MAIR_EL1` 寄存器中定义的内存属性,决定了该页是否可缓存。对于设备内存,通常设置为 `MT_DEVICE_nGnRE` 类型,表示“设备内存,不缓存,无重排序限制”。

综上所述,`ioremap` 的本质是一次受控的页表更新操作,它打破了常规内存映射规则,为设备I/O提供了安全、高效的访问通道。理解这一机制有助于我们在复杂系统中诊断映射冲突、避免非法访问,并为后续引入更高级抽象(如 regmap)打下坚实基础。

### 2.1.2 ioremap在内核空间中的页表管理

`ioremap` 的成功运行离不开内核对页表的精细化管理。不同于用户进程的 `mmap`,`ioremap` 操作的是全局内核页表(swapper_pg_dir),这意味着一旦映射建立,所有 CPU 核心均可访问该虚拟地址,前提是它们使用相同的页表上下文。这也带来了同步与一致性挑战,尤其是在 SMP(对称多处理器)系统中。

内核采用了一种延迟映射(lazy mapping)与即时更新相结合的方式。具体来说,`ioremap` 并不会立即填充所有页表项,而是先保留虚拟地址区间,待第一次访问时触发缺页异常(page fault),再由 `do_page_fault()` 调用相应的修复函数完成实际映射。这种方式减少了初始化开销,但也增加了调试难度。

#### 页表管理的核心流程

```c

static int ioremap_pte_range(pmd_t *pmd, unsigned long addr,

unsigned long end, phys_addr_t phys_addr,

pgprot_t prot)

{

pte_t *pte;

pte = pte_alloc_kernel(pmd, addr); // 分配pte表

if (!pte)

return -ENOMEM;

do {

pgprot_val(prot) |= PTE_PROT_NONE; // 标记特殊页

set_pte_at(&init_mm, addr, pte, pfn_pte(phys_addr >> PAGE_SHIFT, prot));

phys_addr += PAGE_SIZE;

} while (pte++, addr += PAGE_SIZE, addr != end);

return 0;

}

```

逐行解析如下:

1. `pte = pte_alloc_kernel(pmd, addr);`

尝试获取对应 `pmd` 下的 `pte` 表。如果尚未分配,则通过 `__pte_alloc_kernel` 分配一页内存作为 PTE 表。

2. `do { ... } while (...)` 循环遍历当前 PMD 覆盖的所有页。

- `pgprot_val(prot) |= PTE_PROT_NONE;` 添加特殊页标记,告知内核此页不可用于普通内存操作。

- `pfn_pte(...)` 将物理页帧号(PFN)与保护位组合成 PTE 条目。

- `set_pte_at()` 是架构相关函数,负责将 PTE 写入指定位置,并根据需要刷新 TLB。

该函数被 `ioremap_page_range()` 层层调用,形成完整的页表链路。

#### 多级页表映射表格说明

| 层级 | 名称 | 功能 | 是否必须存在 |

|------|------|------|---------------|

| PGD | Page Global Directory | 一级页目录 | 是 |

| PUD | Page Upper Directory | 二级(x86_64/ARM64) | 可选 |

| PMD | Page Middle Directory | 三级 | 可选 |

| PTE | Page Table Entry | 末级,指向物理页 | 是 |

在 ARM64 的 4KB 页面 + 4 级页表配置下,每个 PGD 条目覆盖 512GB,PUD 覆盖 1GB,PMD 覆盖 2MB,PTE 覆盖 4KB。因此,一个 64KB 的寄存器区域需要至少 16 个 PTE 条目,可能跨越多个 PMD。

为了提升效率,Linux 支持巨页映射(huge pages)。若设备寄存器区域足够大且对齐良好(如 2MB 对齐),`ioremap` 可尝试使用 PMD 级别映射,减少 PTE 数量,降低 TLB 压力。这通过 `remap_pfn_range()` 中的 `pgd_populate` → `pud_populate` → `pmd_populate_kernel` 流程实现。

#### TLB与缓存一致性处理

由于 `ioremap` 修改的是全局页表,所有 CPU 必须感知这一变化。为此,内核在设置完页表后调用 `flush_tlb_all()` 或更细粒度的 `flush_tlb_kernel_range()` 来清除 TLB 缓存。否则可能出现某些 CPU 仍使用旧页表项的情况,导致访问失败或数据错乱。

同时,由于设备内存通常设置为非缓存(uncached),CPU 的数据缓存(L1/L2 Cache)不会存储这些地址的内容。但这并不意味着完全绕过缓存系统。某些架构(如 ARM)仍可能通过 Write Buffer 或 Store Queue 进行写操作排队。因此,频繁的寄存器写入之间应插入内存屏障(memory barrier):

```c

writel(value, base + REG_CTRL);

wmb(); // 写屏障,确保写操作顺序提交

writel(1, base + REG_TRIGGER);

```

否则,第二个写操作可能早于第一个到达设备,引发不可预测行为。

#### 错误处理与调试手段

当 `ioremap` 失败时,通常返回 `NULL`。常见原因包括:

- 虚拟地址空间不足(vmalloc space exhausted)

- 物理地址无效或未对齐

- 权限不足(如尝试映射 Secure World 地址)

可通过以下命令查看当前映射状态:

```bash

cat /proc/vmallocinfo | grep ioremap

```

输出示例:

```

f1000000-f1001000 : [c0000000.io] ioremap (phys=f1000000, len=4096)

```

此外,启用 `CONFIG_DEBUG_VM` 后,内核可在 `vm_struct` 分配时进行边界检查和重复检测,帮助发现潜在 bug。

综上,`ioremap` 在内核页表管理中扮演着桥梁角色,它不仅连接了物理设备与软件抽象,也暴露了操作系统底层机制的复杂性。掌握其页表运作机制,是构建高可靠性驱动的前提条件。

# 3. regmap架构设计与高级特性实践

在现代Linux内核驱动开发中,硬件寄存器的访问已不再局限于简单的`ioremap`映射后直接读写。随着SoC复杂度的不断提升,芯片内部往往集成了数十个功能模块,每个模块又包含多个寄存器域、支持多种总线协议(如I2C、SPI、MMIO),并涉及电源管理、锁机制、位字段操作等高级需求。传统的裸指针式寄存器操作不仅难以维护,还容易引发竞态条件和可移植性问题。

为应对这些挑战,Linux内核引入了 **regmap** —— 一个统一的寄存器访问抽象层。它通过封装底层总线通信细节,提供了一套标准化、可扩展且线程安全的API接口,极大提升了驱动代码的健壮性和复用能力。尤其在音频子系统(ASoC)、PMIC(电源管理集成电路)、传感器、桥接芯片等领域,regmap已成为事实上的标准实现方式。

本章节将深入剖析regmap的设计哲学、核心数据结构及其初始化流程,并结合实际应用场景展示其在批量操作、位字段更新、多域管理等方面的高级特性。我们将从设计理念出发,逐步过渡到具体编程实践,最终通过复杂驱动案例揭示其在系统级优化中的关键作用。

## 3.1 regmap的设计理念与核心数据结构

regmap的存在并非为了替代`ioremap`,而是作为更高层次的抽象工具,解决传统寄存器访问模式中存在的结构性缺陷。其设计初衷源于以下几个现实痛点:

- **异构总线共存**:同一设备可能同时使用I2C控制配置寄存器,而状态寄存器则位于内存映射区域(MMIO)。

- **寄存器访问安全性不足**:原始指针操作缺乏边界检查、并发保护和错误处理机制。

- **重复代码泛滥**:不同驱动对相似寄存器的操作逻辑高度重复,缺乏通用封装。

- **调试困难**:缺少统一的日志追踪和模拟机制,难以定位寄存器误写问题。

为此,regmap提出“**寄存器即资源**”的理念,将寄存器访问视为一种受控的服务调用,而非底层内存操作。这一转变使得驱动开发者可以专注于业务逻辑,而不必纠缠于总线时序或锁竞争等低级细节。

### 3.1.1 统一寄存器访问抽象层的必要性

在过去,针对I2C设备的寄存器读写通常依赖于`i2c_smbus_read_byte_data()`这类专用函数;而对于内存映射设备,则采用`readl/writel`配合`ioremap`完成访问。这种割裂的方式导致驱动代码无法跨平台复用,也增加了测试和验证的成本。

以TI的TAS256x系列智能功放为例,该芯片既可通过I2C进行参数配置,又具备DMA缓冲区映射到PCIe空间的情况。若不使用抽象层,开发者必须分别编写两套访问逻辑,甚至在同一函数中混用两种机制,极易造成逻辑混乱。

而引入regmap后,无论后端是I2C控制器还是MMIO地址,上层API始终保持一致:

```c

regmap_write(map, REG_CTRL, 0x01);

regmap_read(map, REG_STATUS, &val);

```

上述代码无需关心`map`是如何建立的——它可以基于I2C适配器,也可以来自`ioremap`后的虚拟地址。这种一致性显著降低了认知负担,并为后续的性能优化和调试支持提供了基础。

更重要的是,regmap支持**注册回调函数**,允许平台定制读写行为。例如,在某些嵌入式平台上,所有寄存器访问都需经过安全监控代理(Secure Monitor Call, SMC),此时可通过自定义`regmap_bus`结构注入钩子函数,实现透明的安全拦截。

下图展示了regmap在驱动架构中的位置及其与底层总线的解耦关系:

```mermaid

graph TD

A[Driver Logic] --> B[regmap API]

B --> C{regmap_backend}

C --> D[I2C Bus]

C --> E[SPI Bus]

C --> F[MMIO Memory]

C --> G[Platform-specific Wrapper]

D --> H[i2c_client]

E --> I[spi_device]

F --> J[ioremap'd VA]

G --> K[Custom Accessors]

style A fill:#4CAF50,stroke:#388E3C

style B fill:#2196F3,stroke:#1976D2

style C fill:#FF9800,stroke:#F57C00

```

> **图示说明**:regmap作为中间层,屏蔽了底层总线差异,使上层驱动无需感知物理连接方式。这正是其“统一抽象”的核心价值所在。

此外,regmap还天然支持以下高级特性:

- 寄存器缓存(cache)以减少不必要的总线事务;

- 批量读写(bulk access)提升吞吐效率;

- 字段级操作(field manipulation)简化位操作;

- 锁机制集成(mutex/spinlock)防止并发冲突;

- 调试接口暴露(debugfs/sysfs)便于运行时观测。

这些特性的整合,使得regmap不仅仅是一个“更好用的`writel`”,而是一个完整的寄存器生命周期管理系统。

### 3.1.2 regmap_config、regmap_field等关键结构解析

要真正掌握regmap的使用,必须深入理解其核心数据结构。其中最为关键的是 `struct regmap_config` 和 `struct regmap_field`,它们分别定义了regmap实例的行为特征和细粒度访问能力。

#### struct regmap_config:配置模板的核心

`regmap_config` 是创建regmap实例时传入的配置结构体,决定了regmap如何与硬件交互。以下是典型字段详解:

| 字段 | 类型 | 功能说明 |

|------|------|----------|

| `name` | const char * | 实例名称,用于调试日志识别 |

| `reg_bits` | int | 寄存器地址宽度(如8、16、32位) |

| `val_bits` | int | 寄存器值宽度(如8、16、32位) |

| `max_register` | unsigned int | 最大有效寄存器偏移,用于边界检查 |

| `cache_type` | enum regcache_type | 缓存策略(无缓存、flat、map等) |

| `writeable_reg` / `readable_reg` | regmap_access_check | 回调函数,校验某寄存器是否可读/写 |

| `volatile_reg` | regmap_access_check | 指定哪些寄存器不应被缓存(如状态寄存器) |

| `precious_reg` | regmap_access_check | 标记“珍贵”寄存器(如中断状态清零寄存器),避免被意外批量清除 |

下面是一个适用于I2C音频编解码器的配置示例:

```c

static const struct regmap_config wm8960_regmap_config = {

.name = "wm8960",

.reg_bits = 7, // 地址为7位(0x00~0x7F)

.val_bits = 9, // 值为9位,需扩展到16位传输

.max_register = 0x7F,

.cache_type = REGCACHE_RBTREE,

.volatile_reg = wm8960_volatile_reg,

.writeable_reg = wm8960_writeable_reg,

.readable_reg = wm8960_readable_reg,

};

```

> **参数说明**:

> - `.reg_bits = 7` 表明寄存器索引仅占用7位,符合I2C器件常见规范;

> - `.val_bits = 9` 是因为WM8960的部分寄存器使用高位补零的9位格式;

> - `REGCACHE_RBTREE` 启用红黑树缓存,适合稀疏寄存器分布;

> - `volatile_reg` 回调确保诸如`RESET`或`POWER_DOWN`等特殊寄存器不会被缓存误导。

该结构在`regmap_init_i2c()`中被引用,用于构建最终的`struct regmap`对象。

#### struct regmap_field:精细化位字段操作

许多硬件寄存器采用位域(bit-field)设计,例如一个8位寄存器中,bit[7:6]表示增益,bit[5]为静音开关,bit[4:0]为音量等级。传统做法是使用宏定义配合`&=`和`|=`操作,但易出错且不可重用。

regmap提供了 `regmap_field` 机制,允许预先定义字段的位置与宽度,并通过原子操作完成更新。

定义方式如下:

```c

struct reg_field {

u16 reg; // 所属寄存器偏移

u8 lsb; // 最低位编号

u8 msb; // 最高位编号

};

struct regmap_field *regmap_field_alloc(struct regmap *rm,

struct reg_field f);

```

示例:定义一个位于`REG_CTRL1`、占据bit[3:2]的“模式选择”字段:

```c

struct reg_field mode_field = REG_FIELD(REG_CTRL1, 2, 3);

struct regmap_field *mode_fld;

mode_fld = regmap_field_alloc(regmap, mode_field);

if (IS_ERR(mode_fld)) {

ret = PTR_ERR(mode_fld);

goto err;

}

```

之后即可进行字段级读写:

```c

// 设置模式为0b10

regmap_field_write(mode_fld, 2);

// 读取当前模式值

regmap_field_read(mode_fld, &val);

```

这种方式的优势在于:

- 自动处理掩码生成(mask = (1 << (msb-lsb+1)) - 1);

- 支持互斥字段自动加锁;

- 可组合成`regmap_field_bulk`实现多字段批量更新。

更进一步,Linux还提供了宏简化声明:

```c

#define REG_FIELD(_reg, _lsb, _msb) \

{ .reg = _reg, .lsb = _lsb, .msb = _msb }

static const struct reg_field my_fields[] = {

[MODE_SEL] = REG_FIELD(0x10, 2, 3),

[MUTE_EN] = REG_FIELD(0x10, 7, 7),

[VOL_LVL] = REG_FIELD(0x11, 0, 4),

};

```

然后通过`devm_regmap_field_batch_init()`一次性初始化多个字段,极大提升代码清晰度。

综上所述,`regmap_config` 定义了整体行为框架,而 `regmap_field` 提供了微观操作能力,二者共同构成了regmap灵活而强大的基石。

## 3.2 regmap的初始化与配置流程

regmap的初始化过程贯穿设备探测、资源配置与总线绑定三个阶段。其目标是根据设备的具体属性(通常来自设备树),动态构建一个适配特定硬件特性的`regmap`实例。整个流程高度模块化,支持I2C、SPI、MMIO等多种后端类型,体现了Linux设备模型“描述即配置”的设计思想。

### 3.2.1 构建regmap实例:从设备树到regmap_init()

在现代Linux驱动中,regmap的创建通常始于设备树节点的解析。设备树不仅描述了寄存器布局,还可嵌入regmap相关配置信息,从而实现“零代码”级别的初始化自动化。

考虑一个典型的I2C连接的ADC设备:

```dts

adc@48 {

compatible = "ti,ads7950";

reg = <0x48>;

regmap-config = <&ads7950_regmap>;

ads7950_regmap: regmap {

reg-bits = <8>;

val-bits = <12>;

max-register = <0xFF>;

#address-cells = <1>;

#size-cells = <0>;

};

};

```

在此设备树片段中,`regmap-config` 属性指向一个子节点,其中明确指定了地址/值宽度及最大寄存器范围。内核在加载时会自动提取这些信息,并填充至`struct regmap_config`。

对应的驱动代码中,只需调用`devm_regmap_ini

0

0

复制全文